что стало с тамбовским дедом

Тамбовский Дед

Биография

Тамбовский дед (Дед-пидарас, футбольный мячик, дед футбольный мячик) — весёлый дед, живший в селе Селезни рядом с городом Тамбовом. На видео он под эффектом сильного алкогольного опьянения требует от оператора самогон и говорит что его убьют. На Ютубе прославился своими фразами: «Я футбольный мячик!», «Пизди фашистов!», «Я пидорас».

Настоящее имя Владимир Кох. По фамилии можно предположить, что дед по национальности немец. Видимо это послужило причиной для издевательств в детстве среди других детей, что стало ему травмой на всю жизнь. В зрелом возрасте с ним случилась по-настоящему серьезная беда, точно не известно какая. Якобы это было убийство жены и сына бандитами. Тогда Владимир окончательно сошел с ума, а алкоголь только усугубил ситуацию. Пристрастие к алкоголю у Владимира появилось где-то в конце 70-х, из-за чего от него ушла жена, которая потом и вовсе умерла. До 1994-го работал слесарем. Его уволили опять же из-за пьянства. Потеряв работу, Владимир окончательно спился. Дед на то время жил в отвратительных условиях: в доме у него был полнейший хаос, везде валялись пустые бутылки со спиртным. Дальнейшая судьба Тамбовского деда еще более печальная. В 2013-2014 году он умер от сильнейшего алкогольного опьянения и интоксикации. Дом Владимира опечатан.

У Тамбовского деда есть два сурса. Первый сурс (дневной) известен многим, он впервые был залит Хеллаутом 6 ноября 2010 года во ВКонтакте и имел название «Дедок отаке! (Дед-пид*рас)». Предположительно это видел было снято куда раньше, аж в 2003 году в 11:00. В ролике видно, что пьяного деда, идущего по улице и орущего матом, достают толпа каких-то мужиков.

Второй сурс малоизвестен и впервые был залит во ВКонтакте все тем же Хеллаутом, но уже 13 августа 2011 года. Интересно, что Хеллаут в описании под видео пишет, что оригинальное название этого ролика «Чумовой Дед станиция Селезни ( тебя задуют)», однако откуда конкретно взят оригинал уже неизвестно. В этом ролике все в общем-то тоже самое, что и в первом только действие происходит уже ночью. Гораздо позднее эти сурсы попали на YouTube. Якобы в 2010 году первый ролик увидел главный герой и он в предел спился.

Тамбовский дед

«Я футбольный мячик! «

Тамбовский дед (Дед-пидарас, футбольный мячик, дед футбольный мячик) весёлый дед, живший в селе Селезни рядом с городом Тамбовом. На видео он под эффектом сильного алкогольного опьянения требует от оператора самогон и говорит что его убьют. На Ютубе прославился своими фразами: «Я футбольный мячик!», «Пизди фашистов!», «Я пидорас».

Настоящее имя Владимир Кох. По фамилии можно предположить, что дед по Национальности немец. Родился он после второй мировой войны, в школе приходилось менять фамилию, потому что в школе над ним издевались. В зрелом возрасте с ним случилась по-настоящему серьезная беда, точно не известно какая. Якобы это было убийство жены и сына бандитами. Тогда Владимир окончательно сошел с ума, а алкоголь только усугубил ситуацию. Пристрастие к алкоголю у Владимира появилось где-то в конце 70-ых годов,из-за чего от него ушла жена, которая потом и вовсе умерла. До 1994-го года работал слесарем. Но его уволили опять же из-за пьянства. Потеряв работу, Владимир окончательно спился. Дед на то время жил в отвратительных условиях: в доме у него был полнейший хаос, везде валялись пустые бутылки со спиртным. Дальнейшая судьба Тамбовского деда еще более печальная. В 2013-2014 году он умер от сильнейшего алкогольного опьянения и интоксикации. Дом Владимира опечатан.

У Тамбовского деда есть два сурса. Первый сурс (дневной) известен многим, он впервые был залит Хеллаутом 6 ноября 2010 года во ВКонтакте и имел название «Дедок отаке! (Дед-пид*рас)». Предположительно это видел было снято куда раньше, аж в 2003 году в 11:00. В ролике видно, что пьяного деда, идущего по улице и орущего матом, достают толпа каких-то мужиков.

Второй сурс малоизвестен и впервые был залит во ВКонтакте все тем же Хеллаутом, но уже 13 августа 2011 года. Интересно, что Хеллаут в описании под видео пишет, что оригинальное название этого ролика «Чумовой Дед станиция Селезни ( тебя задуют)», однако откуда конкретно взят оригинал уже неизвестно. В этом ролике все в общем-то тоже самое, что и в первом только действие происходит уже ночью. Гораздо позднее эти сурсы попали на YouTube. Якобы в 2010 году первый ролик увидел главный герой и он в предел спился.

Тамбовский Дед Жак Фреско remastered QHD 60 FPS

Используя gigapixel ai и dain app улучшил видео о великом тамбовском деде пидарасе футбольном мячике (он же Жак Фреско). Проект Венера стал явью.

Зачем это? Больной человек.

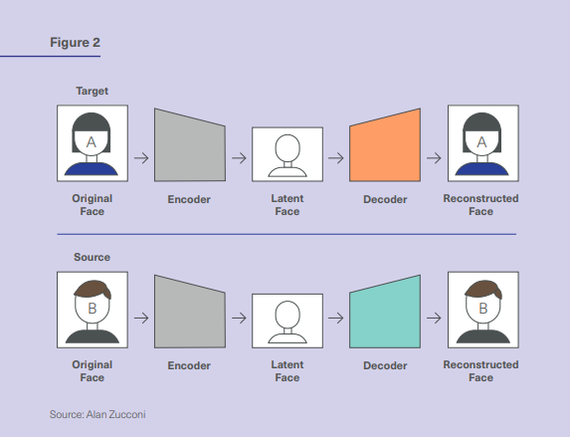

Нейронные сети учатся распознавать Deepfake

Пару недель назад я выложил пост про нейронные сети, которые способны удалять с видео любые движущиеся объекты и всякие следы их существования. Тени от этих объектов, поднятую пыль, иногда даже почти хорошо удалялись волны на воде. И тогда, под тем постом, прямо таки развернулась дискуссия о том, как в принципе можно было бы бороться с подделкой видео. Не только с удалением объектов, но и с теми же дипфейками.

Этим вопросом и задались учёные из Германии и Италии. Ниже прикладываю презентацию их совместной научной работы.

А также, как и в прошлый раз, прикладываю своё собственное видео, с разбором того, а чём именно идёт речь в их презентации.

Итак, краткая выжимка того, о чём именно их работа. Конкретно эта группа учёных не ставила перед собой задачу разработать концептуально новую нейронную сеть, которая бы хорошо распознавала подделку на видео. Они провели комплексную сравнительную работу. Взяли набор видео, часть из которых была отредактированная нейронными сетями, а часть нет. И, с одной стороны, попросили группу людей угадать, какие именно видео являются подделками, а с другой стороны точно такую же задачу поставили перед распространёнными свёрточными нейронными сетями, основная задача которых как раз заключается в распознавании на видео и фотографиях тех или иных объектов. То есть, они брали не специализированные нейросети, а самые обычные. Те, которыми можно распознавать на видео котиков, к примеру.

По сути, самая очевидная идея в данном случае оказывается самой эффективной. Зачем придумывать сложные схемы борьбы с нейросетями, если можно просто заставить бороться с ними другие нейросети. Безусловно, данный метод не является самым надёжным. Но уже сегодня он является наиболее оправданным с позиции точности распознавания и ресурсов, которые требуются на создание такой системы. По факту, использовав созданный учёными в данной работе массив видео для обучения нейросетей, вы сможете у себя дома создать свою собственную систему распознавания дипфейков. Единственным ограничением правда будет время обучения такой сети. Если не использовать видеокарты NVidia старше 20хх серии и разработанную ими же библиотеку для машинного обучения, создание такой сети может затянуться на месяцы. Но тем не менее, такая возможность у вас всё ещё остаётся.

Нейронные сети научились удалять людей с видео

Пару лет назад довольно активно обсуждалась тема deep fake. Технологии, позволяющей заменять лица одних людей на видео другими. Но в том время технология была сырая, даже невооружённым взглядом можно было заметить неестественность изображения. Плавающие контуры лица, искажения пропорций, неестественная мимика и многое другое. Некоторым людям доводилось сделать довольно реалистичные deep fake на небольших отрезках видео, но в какой то момент всё равно вылезала неестественность.

Никаких резких скачков в этой области долгое время не было, поэтому разговоры понемногу сошли на нет. Но данное направление никто не забрасывал и различные группы исследователей и инженеров продолжали работу в этом направлении. И вот в этом году группа исследователей из Оксфорда, Института Вейцмана и Google Research представили систему ансамбля нейронных сетей, способных определять на видео не просто контуры отдельных объектов, но и последствия любых контактов этих объектов с окружающим миром. Поднятую пыль, тени, задетые объекты, даже поднятую рябь на воде. И этот ансамбль нейросетей способен не только всё это определять, но и удалять с видео. Ниже прикрепляю оригинальное видео, представленное авторами разработки.

Поскольку оригинальное видео полностью на английском и в нём описываются лишь базовые особенности работы нейросетей, я также записал видео на русском. В нём я подробнее и простым языком постарался разобрать как саму разработку, так и те принципы, по которым работают нейросети, входящие в ансамбль.

При этом стоит заметить, что данная нейросеть работает абсолютно автономно. И обрабатывать различные видео она способна в «промышленных» масштабах. Есть у неё конечно и ряд ограничений, так что не стоит бояться, что уже завтра можно будет удалить кого угодно с любого видео.

С другой стороны, от появления сетей, которые могли очень криво заменять лица людей, до появления систем, способных практически бесследно удалить любой движущийся объект с видео прошло всего пару лет. И кто знает, чему научатся сети ещё лет через 5-10.

Идеальный дипфейк Моргана Фримена

Датчане из коллектива DiepNep сделали прекрасное видео с Морганом Фрименом. Вот только это совсем не он, а дипфейк. Имитация с помощью современных нейросетей. Даже голос идеально сделан. Ироничный текст, где он спрашивает, что такое реальность. Сделал перевод!

Я хотел бы поприветствовать вас в эпоху синтетической реальности.

Что ты видишь теперь?

Что нас ждет лет через 5, когда такие штуки научатся делать не группы программистов-энтузиастов, а приложения на телефоне?

p.s. нашел у них на фейсбук, что голос таки сделала не нейросеть, а некий Boet Schouwink

вот цитата «Freeman’s voice imitation is done by the incredibly talented Boet Schouwink.»

p.p.s. знаю что боян, но в других постах текста не было, только сам видос

Британский стартап выпустил программу, позволяющую изменять мимику актеров в кино. Так, чтобы она совпадала с дубляжом

Британская компания Flawless выпустила программу TrueSync, которая с помощью машинного обучения синхронизирует дубляж с мимикой актеров. Это значит, что движения губ и лицевых мышц людей на экране будут совпадать с тем, что говорят актеры озвучания. Нейросети сами проанализируют мимику актеров и подстроят под дубляж, заменив их лица на дипфейк. Выглядеть это будет так, будто, к примеру, Роберт Де Ниро изначально во время съемок произносил свои реплики на немецком, а не на английском, как показано в проморолике TrueSync.

Просто взгляните, как это выглядит:

В Китае с помощью сгенерированных изображений аферисты набрали невозвратных кредитов на десятки миллионов долларов

В Китае новый вид мошенничества, который только набирает обороты, но уже позволил похитить из банков десятки миллионов долларов. Виной всему цифровой прогресс.

Популярнейшая технология распознавания лиц, которую глубоко внедрили во все сферы жизни, дала пищу аферистам. Вопрос, который их волновал «а что если для получения кредита использовать несуществующее случайно сгенерированное лицо», ответ был найден быстро.

Старая как мир история: некто обманул государство на десятки миллионов долларов. Но дело не в том, что обманул, а в том, как обманул. Аферисты обогатились, взломав легендарную китайскую систему распознавания лиц. Власти делятся информацией неохотно: Китай стал первым государством, пострадавшим от монстра, которого сам породил.

Системы распознавания лиц здесь повсюду. Чтобы войти в банк, офис или просто во двор, часто не нужны документы, достаточно лица. Система его считает даже в маске, дверь откроется автоматически.

Если есть система, то всегда найдутся желающие ее взломать. Китайский интернет наводнен роликами, где граждане пытаются открыть замки, подставив под око камеры фотографии вместо лиц. Но замки — это детский лепет. Есть более серьезные вещи: технология Face ID в Китае вовсю используется для подтверждения банковских операций и оплате налогов. Этим, уже по-взрослому, и воспользовались аферисты.

– Они создали большое количество автоматически сгенерированных нейронной сетью несуществующих фотографий лиц несуществующих людей. И с помощью технологии дипфейк они смогли их оживить и создать для них несуществующие счета. На протяжении нескольких лет они смогли получить кредиты и в общей сложности около ста миллионов долларов они смогли украсть. Это первое злоупотребление такого рода технологиями, – комментирует Олег Кивокурцев, директор компании по производству сервисных роботов.

Что такое технология дипфейк? Говоря простым языком, это возможность с помощью нехитрых компьютерных манипуляций создать одно лицо из другого. Или заставить, скажем, известных китайских мужчин петь женским голосом. Или даже научить петь кота.

Подобными приложениями активно балуются пользователи соцсетей. Но то забавы ради. Другое дело, когда инструмент попадает в руки людей с дурными намерениями. В США женщина применила технологию дипфейк, чтобы скомпрометировать конкуренток своей дочери, девушек из группы поддержки одной из спортивных команд. Она рассылала интимные видео якобы с их участием. Все было настолько реалистично, что подделку распознала только полиция. И таких случаев все больше.

Китайцев возможность манипуляций с фото и видео беспокоит давно, уже больше года за такое предусмотрена уголовная ответственность, а на местном телевидении один за другим выходят репортажи, как уберечься от мошенников. Имидж еще ладно, но как сохранить деньги?

– С точки зрения противодействия самый, на мой взгляд, эффективный метод – это так называемая двухэтапная идентификация, когда помимо того, что есть изображение, вы подтверждаете действия либо цифровым кодом, либо смс ответным, ну то есть, чтобы ваши операции, связанные с деньгами, предполагала минимум два действия, потому что если вы оставите только одно действие, ну, например, там не знаю, скан с отпечатками пальцев или изображение, то мошенники, используя вот эту методику, могут ее обойти, – говорит Дмитрий Смиркин, IT-специалист.

Все происходящее, конечно, сильный аргумент в пользу того, чтобы держать платежные пароли только в голове, а важные данные записывать от руки на бумажку и класть в сейф. Но прогресс остановить невозможно. Цифровые технологии будут с нами, хотим мы того или нет. Тем важнее наша собственная осмотрительность.

Ответ Koroziablo в «Когда нейтральная армия существ решила присоединиться к твоей армии»

Ответ на пост «Когда нейтральная армия существ решила присоединиться к твоей армии»

А вот Аделаиде думаю прям подошло

Бред Питт, Анджелина Джоли, «Москва слезам не верит» и нейросети

Как делают дипфейки

Вы не могли не видеть роликов, где известным киноперсонажам подставляют лица других актеров. Иногда подобные замены выглядят удивительно достоверно. Сегодня рассказываю про дипфейки.

Таким образом дипфейки используют технологии искусственного интеллекта для синтеза изображений. На сегодняшний день существуют разные архитектуры алгоритмов, которые переносят лица с видео на видео.

Уши, лоб и волосы остаются в целевом видео родными, поскольку алгоритмы пересаживают исключительно область от бровей до подбородка и от уха до уха. В связи с этим нужно находить похожих друг на друга людей или использовать грим, как в случае с коммерческими проектами. На конечный результат цвет кожи и волос, а также комплекция и форма лица. Тот же Хавьер Бардем качественнее поженился со Шваренеггером чем с Ди Каприо или Уиллемом Дэфо, поскольку у них в жизни формы черепа похожи. Также нужно учитывать положение головы и крупность в донорском и целевом видео. Несовпадения принесут плачевные результаты. Оба человека должны побывать в максимально совпадающих условиях и ситуациях. На постпродакшен этапе при помощи композа и масок, конечно, можно докрутить и отшлифовать, но сама по себе технология еще требует серьезной доработки, чтобы выдерживать кинематографическое качество и впоследствии стать мощным инструментом, который бы не накладывал столько ограничений, а наоборот давал гибкость. В менее требовательном, но на более оборотистом рынке рекламы нейросети уже востребованы. А уж сколько однокнопочных сервисов для мобилок появилось. Но важно помнить, что качественный результат всегда требует времени. Тот же проект с Сальвадором Дали потребовал 1000 часов машинного обучения, 6000 фотографий и 146 видео с похожим внешне актером.

Рекламу для Сбера тоже делали ни один месяц. Наконец, для документального фильма «Добро пожаловать в Чечню» также использовали замену лиц, чтобы скрыть личности респондентов. Но там это и не скрывается. Фейк виден невооруженным глазом. Тем не менее это большой и серьезный труд по работе с дублерами и нейросетями, чтобы передать эмоции пострадавших представителей меньшинств.

Можете самостоятельно натренировать нейросеть. Ниже ссылки:

Ушел из жизни Жак Фреско

«За все эти годы я получила много писем, в которых огромное количество людей говорили о том, как их вдохновил Жак Фреско. Он помог им лучше понять, что же происходит в этом мире, но более всего выражалось то, что он дал этим людям надежду, показав, как может выглядеть альтернативное общество, над которым мы можем работать, чтобы преодолеть катастрофические условия, выпавшие на долю человечества.

“Ну ты индеец!” Кем на самом деле был умерший “Дед бомбом”?

На днях стало известно о кончине героя мема “Дед бомбом”. Кем был этот человек в обычной жизни?

Простой работяга

Героя мема звали Михаил Мартынов. Он жил в Туле. Мужчина скончался 16 октября от старости в своей квартире на проспекте Ленина. Ему было 73 года.

По данным тульских СМИ, чаще всего чудак гулял на площади Победы у городского автовокзала, что на все том же проспекте Ленина. Пенсионер развлекал прохожих необычным поведением, строил рожи.

Естественно, что не все были рады приставаниям юродивого.

Неожиданная слава

Мем “Дед бомбом” появился в 2011 году. Журналист местного ТВ опрашивал прохожих и попытался взять интервью у Михаила.

— Можете ли Вы определить погоду на день по внутреннему самочувствию?

— Могу. Знаешь как? Сегодня, значит, ясно. Значит завтра будет… бомбом!

Далее последовали ставшие крылатыми фразы “Ну ты индеец, я балдею!”, “Ладно, не урчи” и “Ну ты француз, бомбом!”

Это видео посмотрели более 1 млн человек. Стали появляться многочисленные мемы с “Дедом бомбом”.

На сегодняшний день группа фанатов Мартынова Вконтакте насчитывает почти 6 тыс. человек.

В Туле стали выпускать сувениры с “Дедом бомбом” и даже соответствующее крафтовое пиво.

14 лет спустя: что стало с дочкой актера Дедюшко, который погиб в аварии вместе с семьей

Известный актер Александр Дедюшко скончался в аварии вместе со своей семьей 3 ноября 2007 года. Позже выяснилось, что 16-летняя дочка артиста от первого брака тоже могла стать жертвой смертельного ДТП – с родителем и его семьей ей помешали поехать неожиданные обстоятельства. С тех пор прошло четырнадцать лет – в этом году Ксении исполнилось 30 лет.

ПО ТЕМЕ

Найден виновный в аварии Дедюшко

Партнерша Дедюшко рассказала правду

В вечер аварии 45-летний Дедюшко направлялся из Владимировской области в Москву вместе с 30-летней женой и сыном, которому едва исполнилось восемь лет. К смерти артиста и его близких привело лобовое столкновение автомобиля с грузовиком на большой скорости. Предполагается, что Александр уснул за рулем. Как стало известно позже, перед ДТП с актером произошло несколько необычных событий.

Во-первых, злополучная авария стала не первой, в которую артист попал 3 ноября 2007 года. До нее автомобиль Дедюшко попал в другое транспортное происшествие в тот же день – обошлось без пострадавших. Во-вторых, актеру не раз приходилось сниматься в киносценах, где его герой попадал в ДТП. К тому же, незадолго до смертельной аварии Александр стал свидетелем гибели каскадера – это произошло во время съемок сцены с наездом на пешехода.

Ксения Дедюшко, дочка артиста от первого брака с Людмилой Томилиной, сделала признание спустя пять лет после аварии. Как оказалось, девушка, которой тогда было 16 лет, должна была провести выходные вместе с отцом и его новой семьей. Однако за два дня до поездки к родителю Ксения заболела ангиной и слегла в постель с высокой температурой.

Наследница Дедюшко признавалась, что у нее были прекрасные отношения с новой семьей отца. Однако ни Ксении, ни ее матери, практически не досталось памяти о покойном Александре. В программе «Прямой эфир» выяснилось, что все имущество актера досталось родным его жены Светланы. Дочь и первая супруга артиста не стали претендовать на наследство и попросили отдать им лишь несколько вещей на память, в том числе награды Александра. Однако родня Светланы потребовала деньги даже за это.